L’intelligenza artificiale, abbreviata IA o AI (inglese per “artificial intelligence“) – è la capacità delle macchine di simulare processi cognitivi umani come l’apprendimento, il ragionamento e la comprensione del linguaggio naturale.

Indice dei contenuti

ToggleSi tratta di una tecnologia chiave della quarta rivoluzione industriale, già oggi alla base di innovazioni che migliorano l’efficienza e ottimizzano processi decisionali in molti settori.

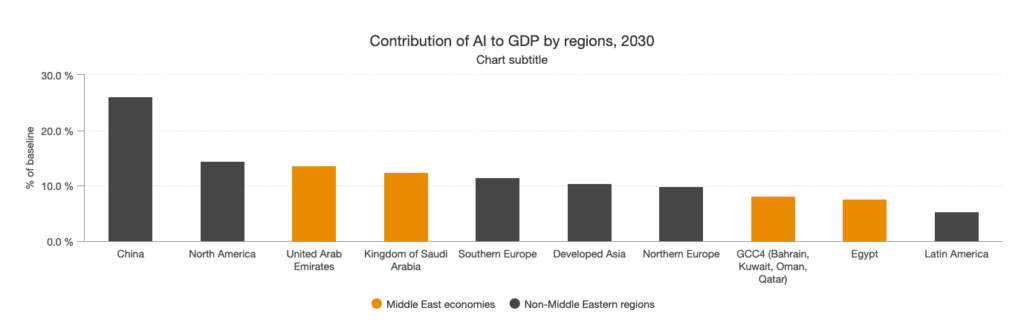

Ad esempio, si stima che l’adozione diffusa dell’IA potrebbe contribuire fino a 15,7 trilioni di dollari all’economia globale entro il 2030.

L’IA sta dunque ridefinendo le interazioni sociali ed economiche, con un impatto sempre più evidente sulla nostra società.

In questo articolo esploreremo le varie tipologie di intelligenza artificiale, esempi di applicazioni pratiche, aspetti etici e cosa ci dobbiamo aspettare in futuro.

Tipologie di Intelligenza Artificiale

Esistono diverse tipologie di IA, generalmente classificate in base al livello di autonomia e generalità delle capacità cognitive esibite. Si va dalle IA deboli o ristrette (ANI), già comuni oggi, fino a ipotetiche IA generali (AGI) e superintelligenze (ASI), ancora oggetto di ricerca e dibattito teorico.

Di seguito illustriamo queste categorie con esempi e caratteristiche:

Intelligenza Artificiale Debole (ANI)

Detta anche IA ristretta o debole, è progettata per svolgere compiti specifici e limitati. Molti sistemi di IA attuali appartengono a questa categoria: ad esempio assistenti vocali come Siri di Apple o Alexa di Amazon, chatbot per il servizio clienti, algoritmi di raccomandazione di Netflix o Amazon, e sistemi di guida autonoma di livello base.

Queste IA eccellono in un ambito ristretto ma non possiedono vera comprensione generale. Un caso emblematico è AlphaGo di DeepMind, il programma che nel 2016 sconfisse il campione mondiale di Go Lee Sedol: un risultato impressionante ottenuto però solo in quel dominio specifico (il gioco del Go).

AlphaGo non sa fare altro – non può ad esempio guidare un’auto o conversare – a conferma che si tratta di IA “specialista” e non di un’intelligenza generale. In generale, le ANI non trasferiscono le proprie competenze ad ambiti diversi da quelli per cui sono state addestrate.

Intelligenza Artificiale Generale (AGI)

Indica un’IA con un livello di intelligenza paragonabile a quello umano in qualsiasi compito cognitivo.

Un’AGI sarebbe in grado di apprendere, capire e adattarsi a situazioni nuove in diversi domini, mostrando flessibilità e forse una forma di consapevolezza. Al momento, l’AGI è teorica e non ancora realizzata (Fonte: Exploring Artificial Intelligence).

Nessun sistema attuale possiede una comprensione generale del mondo o capacità cognitive pienamente versatili come un essere umano.

Tuttavia, la ricerca prosegue: laboratori come OpenAI e DeepMind lavorano verso questo obiettivo, e alcuni esperti sono ottimisti sul fatto che l’AGI possa emergere in questo secolo.

Ad esempio, Ray Kurzweil (direttore engineering di Google) ha previsto che entro il 2029 un’IA potrebbe superare il Turing Test, cioè conversare in modo indistinguibile da un umano.

Restano però pareri contrastanti e grandi sfide tecniche da risolvere prima di raggiungere una vera AGI.

Intelligenza Artificiale Superintelligente (ASI)

È una forma ipotetica di IA che supera di gran lunga l’intelligenza umana in ogni ambito, dalla creatività alla risoluzione di problemi complessi.

Nick Bostrom, filosofo di Oxford, definisce una superintelligenza come “un intelletto che supera di molto le migliori menti umane in molteplici ambiti cognitivi generali” (Fonte: Il pericoloso mito della superintelligenza artificiale – Il Tascabile).

Avere macchine più intelligenti di noi in ogni campo pone interrogativi profondi: come poteremmo controllarle? quali sarebbero i rischi per l’umanità?

Questo scenario infatti alimenta discussioni su rischi esistenziali: alcuni esperti (e noti imprenditori tech) temono che una super-IA fuori controllo possa sfuggire alle regole e perfino minacciare la sopravvivenza umana.

Sebbene tali timori possano sembrare fantascienza, essi evidenziano l’importanza di progettare fin d’ora sistemi sicuri.

Va detto che al momento non esiste nulla di paragonabile a una superintelligenza; si tratta di speculazioni sul futuro, utili però a guidare uno sviluppo etico e controllabile dell’IA avanzata.

Applicazioni e Tecnologie dell’Intelligenza Artificiale

Le tecnologie fondamentali che hanno permesso il boom attuale dell’IA sono principalmente il Machine Learning, il Deep Learning e il Natural Language Processing (NLP), a cui si aggiunge la recente Intelligenza Artificiale Generativa.

In questa sezione descriviamo ciascuna tecnologia, con esempi di utilizzo in aziende o progetti di ricerca, evidenziando i progressi documentati dalla comunità scientifica.

Machine Learning (Apprendimento Automatico)

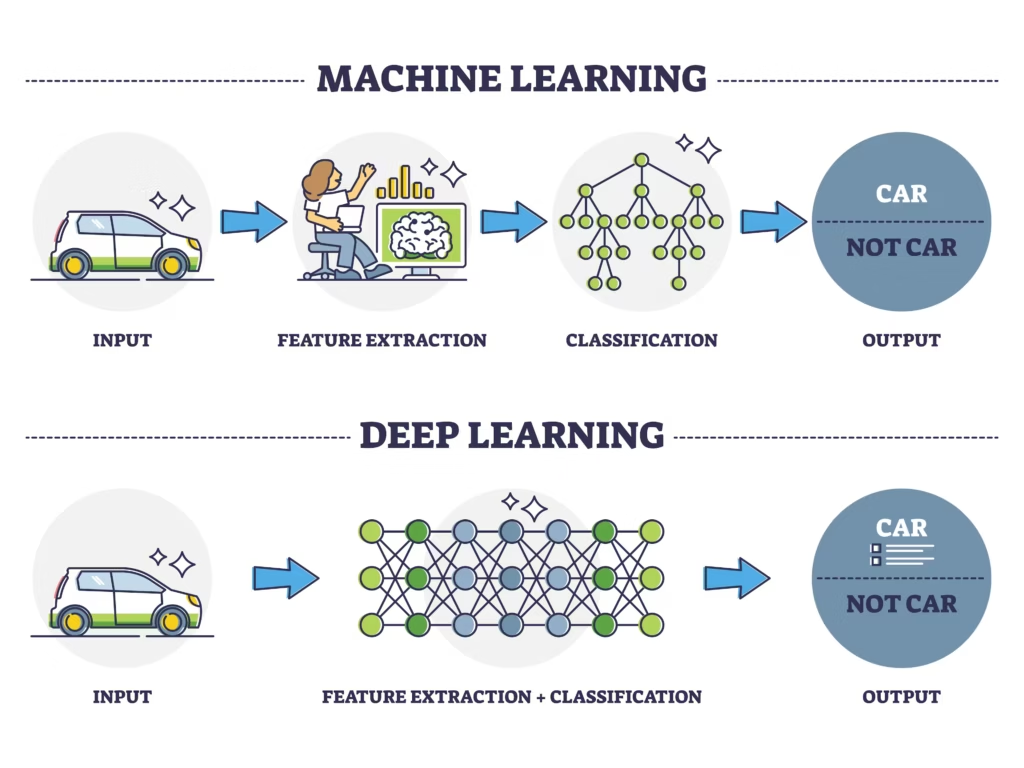

Il machine learning è la branca dell’IA in cui i programmi apprendono dai dati invece di essere esplicitamente programmati. Algoritmi di ML identificano pattern ricorrenti nei dataset e li sfruttano per fare previsioni o prendere decisioni.

Esistono varie forme di ML:

- Supervisionato: l’algoritmo impara da dati etichettati (esempi con la risposta corretta fornita) per poi generalizzare su nuovi dati. Ad esempio, si possono addestrare modelli a partire da migliaia di immagini etichettate di tumori benigni/maligni, così da diagnosticare nuove immagini mediche.

- Non supervisionato: il modello esplora dati non etichettati, cercando autonomamente strutture nascoste (ad es. raggruppando clienti con comportamenti d’acquisto simili).

- Reinforcement Learning: l’algoritmo interagisce con un ambiente e apprende per tentativi ed errori, ricevendo ricompense per le azioni corrette. Questo approccio ha permesso a programmi come AlphaGo di raggiungere prestazioni sovrumane in giochi complessi.

Esempi reali:

Il ML è ampiamente usato. I sistemi di raccomandazione di servizi streaming e e-commerce (Netflix, Amazon) analizzano le preferenze utente per suggerire film o prodotti, migliorando l’engagement.

Questi algoritmi hanno un impatto tangibile: Netflix attribuisce alle sue raccomandazioni una gran parte del tempo di visualizzazione degli utenti, e Amazon utilizza modelli ML per ottimizzare la logistica e la gestione del magazzino.

In ambito industriale, Amazon ha impiegato l’IA per prevedere la domanda durante eventi commerciali come il Cyber Monday, stimando vendite giornaliere di oltre 400 milioni di prodotti e adattando in anticipo le scorte nei centri logistici.

L’uso esteso di ML nella supply chain ha permesso ad Amazon di ridurre i tempi di consegna del 75% in certi contesti e, nel 2020, di risparmiare 1,6 miliardi di dollari in costi di trasporto, tagliando inoltre 1 milione di tonnellate di emissioni CO₂.

Anche nella finanza si usano modelli predittivi per valutare rischi di credito o individuare transazioni fraudolente in tempo reale.

Sul fronte della ricerca, importanti progressi del ML sono stati documentati in compiti un tempo appannaggio esclusivo dell’uomo.

Già nel 2015 una rete neurale di Microsoft (ResNet) ha superato le prestazioni umane nel riconoscimento di immagini dell’insieme ImageNet.

Nel 2019 un modello di elaborazione linguistica di Facebook (RoBERTa, basato su BERT di Google) ha ottenuto risultati migliori di quelli umani in test di comprensione del linguaggio naturale (GLUE benchmark).

Questi traguardi illustrano quanto velocemente il ML stia colmando il divario con le capacità umane in vari compiti.

Deep Learning (Apprendimento Profondo)

Il deep learning è una sotto-disciplina del ML basata su reti neurali artificiali “profonde”, cioè con molti strati di neuroni artificiali ispirati alla struttura del cervello.

Grazie a grandi quantità di dati e potenza computazionale (soprattutto GPU), il deep learning ha compiuto straordinari progressi nell’ultimo decennio. Le reti profonde eccellono in compiti complessi come riconoscimento visivo, riconoscimento vocale, traduzione automatica e altro, spesso raggiungendo o superando prestazioni umane.

Un esempio emblematico è AlphaFold 2 di DeepMind, una rete neurale profonda che nel 2020 ha risolto il cinquantenario “problema del ripiegamento delle proteine”: il sistema ha predetto con elevata accuratezza la struttura 3D di proteine a partire dalla sequenza amminoacidica, vincendo la competizione scientifica CASP14.

I risultati di AlphaFold 2 sono stati descritti come “sbalorditivi” e “trasformativi” dalla comunità scientifica, segnando una svolta nella biologia computazionale.

In altri campi, le reti profonde convoluzionali (CNN) hanno portato il riconoscimento di immagini a livelli di errore bassissimi; le reti ricorrenti e i Transformer hanno rivoluzionato la traduzione e l’analisi di testi. Va notato che i modelli di deep learning spesso funzionano come “scatole nere”, ossia non è chiaro nemmeno agli sviluppatori quale logica interna abbiano appreso.

Questa opacità (black-box) può essere problematica in applicazioni critiche, perché rende difficile spiegare le decisioni: ad esempio, se un’auto a guida autonoma (controllata da reti neurali) commette un incidente imprevisto, non è semplice risalire alla catena di ragionamento che ha portato all’errore (Fonte: AI’s mysterious ‘black box’ problem, explained | University of Michigan-Dearborn).

Nonostante tali sfide, il deep learning rimane il motore di gran parte dei progressi recenti dell’IA. Oggi sta abilitando sistemi come veicoli autonomi di livello avanzato (Waymo, Tesla), in cui reti neurali analizzano in tempo reale le immagini dei sensori per identificare ostacoli e prendere decisioni di guida.

Le auto di Waymo, ad esempio, hanno già percorso oltre 25 milioni di miglia su strade pubbliche, mostrando tassi di incidenti inferiori rispetto ai guidatori umani in condizioni analoghe.

Questi risultati alimentano la fiducia nel fatto che il deep learning possa rendere possibili veicoli più sicuri e una mobilità più efficiente in futuro.

Natural Language Processing (Elaborazione del Linguaggio Naturale)

Il Natural Language Processing (NLP) è il campo dell’IA focalizzato sulla comprensione e generazione del linguaggio umano da parte delle macchine.

Grazie a tecniche di ML e DL, il NLP ha fatto passi da gigante: oggi abbiamo traduttori automatici di alta qualità, assistenti virtuali capaci di sostenere conversazioni e analisi semantiche su larga scala.

Ad esempio, Google Translate utilizza modelli neurali sequenza-sequenza (neural machine translation) che colgono contesto e significato, offrendo traduzioni molto più accurate rispetto ai sistemi di un decennio fa.

Altre applicazioni includono l’analisi del sentiment (estrarre opinioni positive/negative da recensioni o post sui social), il riassunto automatico di documenti e il question answering (sistemi che rispondono a domande attingendo da una base di conoscenza).

Un avanzamento notevole è rappresentato dai modelli linguistici di grandi dimensioni (LLM) come GPT-3 di OpenAI (e il successivo GPT-4): reti neurali con decine di miliardi di parametri addestrate su enormi quantità di testo. GPT-3 è in grado di generare testi coerenti in risposta a un prompt, svolgere compiti come scrivere codice o fare ragionamenti, mostrando una sorprendente versatilità.

Studi hanno rilevato che testi prodotti da modelli come GPT-3 possono risultare difficilmente distinguibili da testi scritti da umani in contesti generici, tanto che questi sistemi hanno superato benchmark di linguaggio complessi e fatto emergere questioni su copyright e plagio (essendo in grado di produrre articoli o temi scolastici quasi perfetti).

Allo stesso tempo, i LLM soffrono di alcuni limiti: mancanza di vera comprensione, possibilità di generare informazioni inesatte (allucinazioni), e incorporazione di bias presenti nei dati di training (vedi sezione etica). Nonostante ciò, il progresso nel NLP è evidente.

Nel 2019, il modello BERT di Google ha raggiunto risultati allo stato dell’arte in 11 diverse attività di comprensione del linguaggio, e come citato prima, la sua variante RoBERTa ha superato la media umana nel test GLUE.

Queste tecniche di linguaggio naturale alimentano oggi chatbot avanzati e sistemi di domanda-risposta: basti pensare a assistenti virtuali come Alexa o Google Assistant, o ai chatbot implementati nei servizi clienti che possono rispondere automaticamente a molte domande comuni.

Inoltre, strumenti di ricerca semantica e analisi di testi legali o medici stanno diventando preziosi alleati per professionisti, setacciando enormi corpus testuali in poco tempo.

Il NLP è anche un componente chiave delle applicazioni di IA generativa descritte di seguito.

Intelligenza Artificiale Generativa (GenAI)

L’IA generativa è una branca emergente dell’IA in cui i modelli non si limitano a analizzare dati, ma generano contenuti originali: testi, immagini, audio, video. Questo è reso possibile da reti neurali addestrate a modellare la distribuzione dei dati di input e a produrne di nuovi con caratteristiche simili. Due delle tecniche principali sono:

- GAN (Generative Adversarial Networks): coppie di reti neurali in competizione (generatore vs discriminatore) che possono creare immagini estremamente realistiche, volti umani sintetici indistinguibili da foto reali, ecc.

- LLM (Large Language Models): modelli linguistici di grandi dimensioni (come GPT-3/4) che generano testo coerente e creativo dato un prompt.

Applicazioni della GenAI

Negli ultimi anni abbiamo assistito a applicazioni pratiche notevoli:

- Creazione di testi e conversazioni: chatbots avanzati e assistenti virtuali come ChatGPT, Bard di Google o Claude di Anthropic possono redigere email, articoli o dialogare con l’utente fornendo informazioni e idee. Ad esempio, ChatGPT è stato adottato da milioni di utenti per scrivere codice, riassumere documenti o ottenere spiegazioni su vari argomenti. Ha raggiunto i 100 milioni di utenti in sole 8 settimane, diventando l’app consumer a crescita più rapida di sempre, a testimonianza dell’interesse verso queste tecnologie.

- Immagini generate da AI: strumenti come Midjourney, Stable Diffusion e DALL-E 2 permettono di creare immagini originali a partire da una descrizione testuale (prompt). Questi sistemi vengono usati per il design grafico, la pubblicità, l’arte digitale: ad esempio, illustratori e game designer li impiegano per prototipare scenari e personaggi in pochi minuti.

- Video generativi: sebbene più complessa, anche la generazione di video sta muovendo i primi passi con strumenti come Runway (che consente di trasformare testo in brevi videoclip), Pictory o Synthesia (che genera video con presentatori virtuali a partire da uno script). Ciò apre prospettive per contenuti multimediali personalizzati e simulazioni.

- Musica e audio sintetico: modelli come Jukebox (di OpenAI) compongono musica in vari stili, e altre IA generano voci artificiali indistinguibili da quelle umane, con usi che vanno dagli audiolibri ai dialoghi nei videogiochi.

- Innovazione e brainstorming: la GenAI è anche un assistente creativo. Supporta autori e inventori nella fase di ideazione – ad esempio suggerendo plot narrativi, design di prodotti o soluzioni a problemi tecnici – ampliando la gamma di possibilità considerate dall’umano.

Queste applicazioni generative, pur straordinarie, sollevano nuove sfide su diritti d’autore (i modelli spesso sono addestrati su opere esistenti) e veridicità dei contenuti (deepfake e disinformazione). Sono però indubbiamente uno dei fronti più dinamici dell’IA odierna e futura, con investimenti enormi in ricerca e sviluppo.

Applicazioni Pratiche dell’Intelligenza Artificiale

Le tecnologie descritte trovano impiego concreto in molteplici settori, rivoluzionandoli. Di seguito presentiamo alcuni casi d’uso significativi dell’IA in contesti reali – dalla sanità all’industria – citando strumenti e studi che ne evidenziano i benefici.

Educazione

L’IA sta contribuendo a personalizzare e migliorare l’apprendimento. Piattaforme educative intelligenti come Duolingo utilizzano algoritmi per adattare gli esercizi al livello e al ritmo di ciascun discente: analizzano le risposte dell’utente e identificano punti di forza e debolezza, per poi modificare dinamicamente le lezioni successive in modo da colmare le lacune.

Questo approccio personalizzato mantiene alta la motivazione e rende lo studio più efficace. Oltre alle app, si stanno diffondendo tutor virtuali basati su IA: sistemi che possono porre domande allo studente, fornire spiegazioni aggiuntive quando nota difficoltà, e persino valutare compiti aperti.

Ad esempio, un recente studio di Stanford ha testato un assistente AI chiamato TutorCoPilot integrato in sessioni di tutoraggio matematico: i risultati hanno mostrato che gli studenti seguiti da tutor umani supportati dall’IA miglioravano le performance di circa il 4% rispetto a studenti con tutor tradizionali.

Ciò suggerisce che l’IA può amplificare l’efficacia dell’insegnamento, aiutando i docenti a individuare meglio le necessità individuali.

Inoltre, l’IA viene impiegata per automatizzare attività amministrative (es. pianificazione orari, gestione delle iscrizioni) nelle scuole e università, liberando tempo prezioso per le attività didattiche.

In prospettiva, un uso etico dell’IA in educazione potrebbe democratizzare l’accesso a tutoraggio di alta qualità su larga scala, offrendo ad ogni studente un’esperienza di apprendimento su misura.

Sanità

In campo sanitario l’IA sta dando un contributo rivoluzionario in diagnosi, terapie e ricerca medica. Uno degli utilizzi di punta è l’analisi di immagini mediche: algoritmi di visione artificiale (reti neurali convoluzionali) addestrati su migliaia di radiografie, TAC o risonanze imparano a riconoscere segni precoci di malattie.

Ad esempio, sistemi di IA hanno raggiunto accuratezza pari o superiore a radiologi esperti nel rilevare noduli polmonari o lesioni tumorali in imaging diagnostico.

Un noto studio pubblicato su Nature ha mostrato che un modello di deep learning poteva individuare il cancro al seno su mammografie con meno falsi negativi rispetto a diversi radiologi, segnalando casi sfuggiti all’occhio umano.

Allo stesso tempo, l’IA permette di personalizzare trattamenti: incrociando la storia clinica e genetica di un paziente con vasti database di letteratura medica, algoritmi di machine learning possono suggerire terapie mirate con maggiore probabilità di successo.

Un esempio è l’uso di IBM Watson for Oncology (in sperimentazione) per supportare i medici nelle scelte terapeutiche per il cancro, basandosi su migliaia di articoli scientifici.

Inoltre, l’IA è impiegata nello sviluppo di farmaci: aziende come DeepMind hanno usato modelli (vedi AlphaFold) per prevedere strutture proteiche, aiutando a progettare nuovi farmaci in tempi più rapidi.

Anche l’assistenza ai pazienti beneficia dell’IA: chatbot medici e app di telemedicina (ad es. Babylon Health) forniscono un primo triage dei sintomi 24/7, consigliando se è il caso di rivolgersi a uno specialista.

In ospedale, sensori intelligenti monitorano costantemente parametri vitali nei reparti intensivi, allertando il personale prima che si verifichino crisi (sistemi di early warning per sepsi, ad esempio).

L’insieme di queste applicazioni migliora l’accuratezza diagnostica e l’efficienza del sistema sanitario, con potenziale di salvare vite tramite interventi più tempestivi e mirati.

Industria e Manifattura

Nel settore industriale e manifatturiero, l’IA è un motore di automazione avanzata e ottimizzazione dei processi.

Una delle applicazioni principali è la manutenzione predittiva: sensori IoT installati su macchinari raccolgono dati (vibrazioni, temperature, rumori) analizzati da algoritmi ML che prevedono possibili guasti prima che accadano.

Ciò permette di effettuare interventi di manutenzione solo quando necessario, evitando costosi fermi impianto.

Secondo analisi di McKinsey, l’uso dell’IA nella manutenzione può ridurre i tempi di fermo macchina fino al 50%, con risparmi enormi e aumento della vita utile degli asset.

Grandi aziende come Siemens e GE hanno implementato queste soluzioni nei loro impianti e in quelli dei clienti (turbine, motori aeronautici, ecc.), riferendo decisi miglioramenti nell’affidabilità operativa.

Un altro ambito è il controllo qualità automatizzato: con visione artificiale, le linee di produzione possono ispezionare in tempo reale i prodotti (ad es. rilevare micro-difetti su chip o imperfezioni in auto verniciate) con una velocità e precisione superiore all’occhio umano, scartando subito i pezzi fallati.

Nelle catene di montaggio avanzate (smart factory), robot collaborativi guidati da IA lavorano accanto agli operai umani, adattandosi in modo flessibile al ritmo e ai compiti richiesti.

Ad esempio, i robot mobili Kiva nei magazzini Amazon – coordinati da algoritmi – spostano gli scaffali ottimizzando i percorsi, dimezzando i tempi di prelievo degli articoli.

L’ottimizzazione della supply chain è un ulteriore campo: il ML viene usato per prevedere la domanda di prodotti in ogni area geografica (tenendo conto di stagionalità, trend di ricerca online, ecc.) e per pianificare di conseguenza la produzione e distribuzione.

Amazon ha dichiarato che grazie ad algoritmi AI per il routing delle consegne e la gestione delle scorte, ha potuto soddisfare la crescita dell’e-commerce mantenendo tempi di consegna molto rapidi.

Infine, l’IA viene applicata anche al design industriale, attraverso l’ottimizzazione topologica (software intelligenti che progettano componenti con forme innovative, più leggere e robuste di quelle ideate manualmente) e alla gestione dell’energia negli impianti (sistemi che regolano dinamicamente i consumi di macchinari e climatizzazione per ridurre gli sprechi).

In sintesi, nelle fabbriche l’IA sta incrementando produttività, qualità e sicurezza, gettando le basi per una Industria 4.0 completamente interconnessa e autonoma.

Mobilità e Trasporti

Il settore dei trasporti sta vivendo trasformazioni epocali grazie all’IA, con l’avvento di veicoli sempre più autonomi e di una gestione ottimizzata del traffico.

Auto a guida autonoma: aziende come Tesla, Waymo (di Alphabet/Google), GM Cruise e altre hanno sviluppato vetture dotate di sensori (telecamere, lidar, radar) i cui dati sono elaborati in tempo reale da potenti algoritmi di deep learning.

Tali veicoli sono in grado di percepire l’ambiente circostante (riconoscere pedoni, segnali, altri veicoli) e di prendere decisioni di guida. Waymo in particolare ha lanciato servizi sperimentali di taxi senza conducente in alcune città degli USA.

La sua flotta ha accumulato oltre 20 milioni di miglia di test su strade pubbliche e, secondo studi interni confrontati con statistiche nazionali, i tassi di incidenti (per miglio) risultano inferiori del 50-90% rispetto alla guida umana, soprattutto riguardo agli urti con feriti.

Ciò indica il potenziale dell’AI nel migliorare la sicurezza stradale, considerando che la stragrande maggioranza degli incidenti deriva da errore umano. Oltre alle auto, anche autobus navetta autonomi e veicoli logistici senza pilota (per consegne dell’ultimo miglio) sono in fase di test avanzato.

Parallelamente, l’IA sta ottimizzando il traffico urbano: città pilota (ad es. Pittsburgh negli USA) hanno installato semafori intelligenti controllati da algoritmi di reinforcement learning, che regolano le durate del verde in base ai flussi di veicoli in arrivo, riducendo i tempi di attesa e la congestione. Sistemi di questo tipo hanno portato a riduzioni misurate delle code e delle emissioni in alcune intersezioni critiche.

Anche la gestione del trasporto pubblico beneficia di previsioni basate su IA: modelli che analizzano dati storici e in tempo reale per suggerire percorsi ottimali degli autobus, prevenire sovraffollamenti (ad es. modulando la frequenza delle corse in base alla domanda prevista) e informare tempestivamente i viaggiatori su ritardi o alternative.

Nel trasporto aereo, l’IA viene utilizzata per ottimizzare le rotte di volo in funzione del meteo, riducendo consumi, e per la manutenzione predittiva degli aerei (evitando cancellazioni improvvise per guasti).

Infine, la logistica e spedizioni sfrutta ampiamente algoritmi per l’instradamento ottimale dei pacchi: UPS e DHL hanno sviluppato sistemi IA che calcolano il percorso di consegna migliore tenendo conto di traffico, finestre orarie di destinatari e altri vincoli, tagliando milioni di miglia percorse ogni anno.

In sintesi, dall’auto personale al trasporto merci, l’IA sta incrementando l’efficienza e la sicurezza della mobilità, avvicinandoci a un futuro di trasporti più intelligenti e sostenibili.

Marketing e Comunicazione

L’IA ha trovato terreno fertile anche nel marketing, dove la personalizzazione e l’analisi dei dati sono fondamentali.

Oggi le grandi piattaforme online (Google, Facebook/Meta, Amazon) utilizzano sofisticati algoritmi di machine learning per profilare gli utenti in base al loro comportamento (ricerche effettuate, like sui social, acquisti, ecc.) e per personalizzare contenuti pubblicitari su misura.

Questo significa che ogni utente vede annunci (banner, post sponsorizzati, consigli di prodotti) differenti, selezionati dall’IA perché ritenuti più rilevanti per i suoi interessi.

La pubblicità mirata così ottenuta ha tassi di conversione nettamente superiori alla pubblicità tradizionale generica.

Un sondaggio recente mostra che circa l’88% dei marketer utilizza quotidianamente l’IA nelle proprie attività: dalle piattaforme di email marketing che decidono l’orario migliore per inviare una campagna a ciascun destinatario, ai tool che generano automaticamente varianti di testo e grafica di un annuncio testandole sul pubblico (concetto di A/B testing automatizzato).

Leggi anche: AI Marketing.

Esempi concreti:

Netflix non solo consiglia film, ma personalizza perfino l’immagine di copertina di uno stesso film enfatizzando l’attore o il genere preferito dall’utente, grazie ad algoritmi di computer vision.

Su Amazon, l’IA determina l’ordine di visualizzazione dei prodotti nelle ricerche (tenendo conto di ciò che ha più probabilità di piacere e essere acquistato da quella persona) e ottimizza dinamicamente i prezzi con tecniche di reinforcement learning per massimizzare le vendite.

Nel settore bancario, l’IA segmenta la clientela e permette di proporre l’offerta giusta (es. un prestito, una carta di credito) al cliente giusto tramite il canale giusto, nel momento più opportuno.

Oltre alla personalizzazione, si utilizzano chatbot IA per il customer service e il social media marketing: rispondono automaticamente alle domande frequenti dei clienti su siti web e pagine Facebook, oppure generano post social e newsletter in linguaggio naturale a partire da pochi punti chiave inseriti dal team marketing.

In ambito retail, catene come Starbucks hanno adottato sistemi di predictive analytics che, basandosi su meteo, eventi locali e preferenze individuali (dalla app loyalty), inviano offerte mirate (ad esempio uno sconto su una bevanda specifica se fa molto caldo) aumentando notevolmente il tasso di visita nei punti vendita.

Tutto questo si traduce in un marketing più efficace e mirato, in cui l’IA assume molti compiti analitici un tempo manuali.

Da notare che i consumatori stessi stanno iniziando a riconoscere questo trend: oltre l’80% si dice favorevole ad avere consigli personalizzati tramite IA, purché sia garantita la trasparenza sull’uso dei propri dati personali.

Questo ci porta direttamente agli aspetti etici, cruciali soprattutto in ambito marketing (dove c’è di mezzo la privacy degli utenti).

Aspetti Etici dell’Intelligenza Artificiale

Il rapido sviluppo dell’IA solleva importanti questioni etiche e di responsabilità sociale. È fondamentale affrontare questi temi per evitare che i progressi tecnologici producano effetti indesiderati o dannosi.

Di seguito analizziamo alcuni rischi e problemi etici chiave – come i bias algoritmici, la trasparenza e la privacy – riportando casi concreti in cui si sono manifestati e iniziative messe in atto per mitigarli.

Bias e discriminazione algoritmica

I sistemi di IA possono ereditare o persino amplificare i pregiudizi (bias) presenti nei dati di addestramento. Ciò può portare a decisioni discriminatorie ai danni di certi gruppi demografici.

Un caso famoso è quello di un algoritmo di selezione del personale sviluppato da Amazon: addestrato sui CV ricevuti dall’azienda nell’ultimo decennio (in gran parte da candidati uomini, dato lo squilibrio del settore tech), il modello aveva “imparato” a penalizzare le candidate donne – ad esempio declassando i CV contenenti la parola “women’s” (come in “Women’s chess club”).

Appena emerso il problema, Amazon ha dovuto ritirare nel 2018 questo strumento, riconoscendo che non garantiva pari opportunità.

Nel campo del face recognition, uno studio del MIT Media Lab ha rilevato che tre diffusi sistemi commerciali di riconoscimento facciale avevano errori minimi (0–1%) nell’identificare il genere di volti di uomini caucasici, ma errori molto più alti nel caso di donne con pelle scura – con tassi di errore fino al 34%.

In altre parole, questi sistemi funzionavano peggio proprio per le persone di colore e di genere femminile, a causa di dataset di training sbilanciati (molte immagini di uomini bianchi, poche di donne nere).

Questo genere di bias algoritmico ha implicazioni serie se tali sistemi vengono usati, ad esempio, dalla polizia: sono documentati casi in cui software di riconoscimento facciale hanno portato ad arresti erronei di persone afroamericane innocenti, scambiate per altri.

Per affrontare i bias, la comunità sta sviluppando tecniche di AI Fairness: ad esempio dataset più equilibrati, metodi per “spiegare” e auditare le decisioni dei modelli, e tool open-source come IBM AI Fairness 360 per rilevare disparità di trattamento.

Diverse aziende (es. Microsoft, Google) hanno inoltre istituito team interni etici per esaminare gli algoritmi prima del rilascio.

Dal punto di vista normativo, l’Unione Europea con il prossimo AI Act richiederà valutazioni d’impatto sui diritti fondamentali per i sistemi IA ad alto rischio, includendo la verifica di assenza di bias discriminatori.

Trasparenza e spiegabilità

Molti modelli di IA, specie quelli basati su deep learning, operano come scatole nere – forniscono output (decisioni, previsioni) senza che sia comprensibile il perché.

Questa mancanza di trasparenza è problematica in contesti critici: ad esempio, se un algoritmo AI rifiuta la richiesta di un prestito bancario o decide il punteggio di idoneità di un candidato a un lavoro, la persona coinvolta ha diritto a sapere le motivazioni.

Analogamente, in ambito sanitario e legale è fondamentale poter giustificare una decisione automatizzata (es: “Perché il sistema diagnostico AI non ha segnalato questa radiografia come sospetta?” oppure “Perché questo detenuto è stato valutato ad alto rischio di recidiva dalla piattaforma usata dal tribunale?”).

Ad oggi, spiegare le ragioni interne di una rete neurale complessa non è banale – è un campo di ricerca chiamato XAI (eXplainable AI).

Si stanno sviluppando metodi come LIME e SHAP, che evidenziano quali caratteristiche in input hanno pesato di più sulla decisione, fornendo una sorta di interpretazione approssimativa comprensibile agli umani.

Un altro approccio sono le “model cards” proposte da Google: documenti che accompagnano un modello indicando i suoi obiettivi, i dati di addestramento, le metriche di performance e i limiti noti, un po’ come bugiardini per farmaci.

Sul fronte legislativo, il GDPR europeo già sancisce (all’Art.22) il diritto a non essere sottoposti a decisioni automatizzate senza possibilità di intervento umano, e implica un certo diritto alla spiegazione in ambito di processi decisionali automatizzati significativi.

In generale, c’è una crescente attenzione a rendere gli algoritmi “accountable”: negli USA, ad esempio, alcune giurisdizioni richiedono audit indipendenti sugli algoritmi usati in ambito pubblico (come i sistemi di punteggio dei detenuti).

La spiegabilità assoluta dei modelli più complessi resta una meta lontana, ma trasparenza e controllo umano sono principi guida sempre più riconosciuti nello sviluppo di IA affidabili.

Privacy e utilizzo dei dati personali

L’IA prospera analizzando grandi moli di dati, molti dei quali possono essere informazioni personali (foto, testi, cronologie di navigazione, dati sanitari, ecc.).

Ciò solleva preoccupazioni sul diritto alla privacy degli individui. Un caso emblematico è quello di Clearview AI, una startup che ha raccolto senza autorizzazione oltre 3 miliardi di immagini di volti dal web (da social network, blog, ecc.) per addestrare un suo algoritmo di riconoscimento facciale.

Questo database è stato offerto a forze dell’ordine e altri clienti, permettendo di identificare praticamente chiunque da una foto.

Tali pratiche violano chiaramente le normative europee: il GDPR vieta la raccolta e uso di dati biometrici (come le foto del volto) senza il consenso esplicito dell’individuo e senza informarlo sugli scopi.

Non a caso il Garante Privacy di diversi paesi UE, Italia compresa, hanno dichiarato illegale l’operato di Clearview e comminato multe (in UK una sanzione da 7,5 milioni di £, in Italia 20 milioni €).

L’azienda è stata diffidata dal continuare queste attività in Europa. Questo esempio evidenzia il conflitto tra le potenzialità dell’IA e la tutela della privacy: da un lato poter identificare chiunque in un luogo pubblico con una telecamera può aiutare a trovare criminali, dall’altro crea una società orwelliana di sorveglianza totale.

I legislatori stanno correndo ai ripari: oltre al GDPR già in vigore, la bozza di EU AI Act prevede il divieto di sistemi di identificazione biometrica remota in tempo reale in spazi pubblici per scopi di law enforcement (salvo strettissime eccezioni).

Anche in ambito non biometrico, la privacy è cruciale: basti pensare ai dati raccolti dagli assistenti vocali in casa (Alexa, Google Home) o alle app che tracciano posizione e attività – è fondamentale che vengano rispettate le norme e che l’utente mantenga il controllo dei propri dati.

Strumenti come l’anonimizzazione e la privacy differenziale vengono applicati per poter addestrare modelli utili senza violare la riservatezza individuale.

Ad esempio, Apple e Google hanno introdotto tecniche per eseguire il machine learning “on device” (sul dispositivo dell’utente) senza inviare dati grezzi ai server, oppure per aggiungere rumore statistico ai dati aggregati in modo che non sia possibile risalire al singolo.

La sfida è trovare il bilanciamento tra innovazione dell’IA e protezione dei diritti personali: organizzazioni internazionali come l’UNESCO hanno emanato linee guida etiche e molti enti stanno definendo principi di “Trustworthy AI” centrati su privacy, trasparenza e non discriminazione.

Responsabilità e consenso informato

Un ultimo aspetto etico riguarda la responsabilità delle azioni compiute dall’IA e il consenso informato delle persone coinvolte.

Se un’auto autonoma causa un incidente, di chi è la colpa? Del produttore, del proprietario, dello sviluppatore software?

Questo tema della responsabilità algoritmica è oggetto di dibattito legale: occorrerà probabilmente aggiornare leggi e assicurazioni per coprire scenari in cui una “macchina” prende decisioni. Similmente, quando si utilizzano sistemi AI che influenzano la vita delle persone, è etico che queste ne siano al corrente.

Ad esempio, se chattiamo con un servizio clienti, abbiamo diritto di sapere se stiamo parlando con un chatbot IA anziché con un umano. Il consenso informato è centrale anche in medicina: se un medico supporta le sue diagnosi con un algoritmo, il paziente dovrebbe essere informato dell’uso di tale strumento e delle relative percentuali di errore.

Alcune giurisdizioni stanno iniziando a imporre etichette o avvisi: in Australia ad esempio è in discussione l’obbligo di avvisare quando contenuti (foto, video) sono stati generati o alterati da IA, per combattere i deepfake.

L’UE con l’AI Act vuole introdurre requisiti di sorveglianza umana (“human oversight”) per i sistemi ad alto rischio, così che una persona possa sempre intervenire e prevalere sulle decisioni della macchina.

In sintesi, l’etica dell’IA richiede trasparenza verso gli utenti, il loro coinvolgimento nel dare o negare consenso informato all’uso dei propri dati, e chiari meccanismi di attribuzione della responsabilità quando qualcosa va storto a causa di un algoritmo.

Affrontare questi aspetti etici non è solo un dovere morale, ma anche una condizione per generare fiducia nell’IA. In assenza di fiducia, persone e organizzazioni saranno restie ad adottare le soluzioni di IA, vanificandone i benefici potenziali.

Per questo, vi è un consenso crescente sulla necessità di uno sviluppo “human-centric” dell’intelligenza artificiale, in cui i valori umani e i diritti siano incorporati fin dalla fase di progettazione dei sistemi.

Il Futuro dell’IA

Guardando avanti, l’IA promette di esercitare un’influenza ancora più pervasiva su economia e società, con progressi scientifici e tecnologici che ridefiniranno ciò che le macchine possono fare.

Secondo un rapporto del World Economic Forum, entro il 2025-2030 l’IA e l’automazione creeranno circa 170 milioni di nuovi posti di lavoro nel mondo, mentre ne trasformeranno o renderanno obsoleti circa 90 milioni, con un saldo occupazionale positivo del 7%.

Ciò significa nuove professioni (esperti di AI, data scientist, tecnici per la manutenzione di robot, ethics officer per l’IA, ecc.) e la scomparsa di alcuni ruoli tradizionali, soprattutto quelli ripetitivi che possono essere automatizzati.

Il rapporto uomo-macchina sul lavoro è destinato a riequilibrarsi: se oggi poco meno della metà delle attività lavorative è svolta solo da umani e circa un terzo vede coinvolta una qualche automazione, entro il 2030 si prevede che gran parte delle attività saranno svolte in sinergia uomo-IA. Sarà quindi fondamentale puntare sulla formazione e riqualificazione (reskilling) dei lavoratori, per prepararli ai nuovi compiti ad alto valore aggiunto complementari all’IA.

I governi e le aziende sono chiamati ad affrontare questa transizione: il WEF sottolinea l’urgenza di investire in formazione digitale e scientifica su larga scala, per evitare un aumento della disoccupazione tecnologica e cogliere invece le opportunità di crescita.

Sul fronte economico, oltre alla creazione di ricchezza, l’IA può contribuire a incrementare la produttività in settori maturi e ad accelerare la ricerca scientifica.

Ad esempio, combinando IA e simulazioni al computer potrebbe diventare possibile scoprire nuovi materiali con proprietà desiderate (superconduttori, leghe ultraleggere) molto più velocemente che con la sperimentazione tradizionale. In medicina, l’IA unita a tecnologie come CRISPR e biotecnologie avanzate apre la strada a terapie personalizzate per malattie finora incurabili.

Dal punto di vista tecnologico, ci si aspetta un continuo miglioramento degli algoritmi esistenti e l’emergere di nuovi paradigmi. I modelli di IA generativa diventeranno ancora più potenti e affinati: immagini e video generati saranno indistinguibili dal reale, i chatbot diventeranno sempre più “intelligenti” e contestualizzati (anche se probabilmente non dotati di vera coscienza).

Si lavorerà per superare limiti attuali come le allucinazioni dei modelli linguistici, integrando le capacità generative con moduli di verifica dei fatti e con basi di conoscenza attendibili. Un’altra area in fermento è l’AI neuromorfica: sviluppare hardware e modelli ispirati al cervello umano non solo nell’architettura (reti neurali) ma anche nel funzionamento (circuiti che comunicano con impulsi asincroni come i neuroni biologici).

Questo potrebbe portare a incrementi di efficienza energetica enormi – oggi gli algoritmi di deep learning consumano molta energia – aprendo l’IA a dispositivi integrati ovunque (IoT intelligente). Parallelamente, l’integrazione tra AI e robotica diventerà più stretta: avremo robot umanoidi o specifici per compiti (esoscheletri, droni autonomi) con capacità cognitive avanzate per interagire in modo naturale nell’ambiente umano.

Ciò potrebbe significare robot badanti per gli anziani, assistenti domestici diffusi, oltre a intere fabbriche robotizzate con supervisione minima. Sul fronte dell’AGI, alcuni ricercatori ritengono che l’aumento delle dimensioni dei modelli (parametri) non sarà sufficiente: serviranno nuove idee, magari combinare simbolico e statistico (le vecchie AI basate su regole con le nuove basate su dati) per raggiungere un’intelligenza più generale.

Non manca poi chi pensa alla quantum AI: utilizzare computer quantistici per eseguire algoritmi di machine learning più potenti di quelli odierni; questa è una frontiera ancora sperimentale, ma che in futuro potrebbe risolvere problemi complessi in tempo ridotto.

Infine, il futuro dell’IA dipenderà in larga misura da come sapremo governarla. L’auspicio di molti esperti è che si instauri un circolo virtuoso: norme e standard etici solidi che guidino l’innovazione in una direzione positiva, e un dialogo continuo tra scienziati, imprese, politici e società civile. Solo così si potranno massimizzare i benefici (medicina migliore, meno fatica sul lavoro, prodotti e servizi più accessibili, aiuto nell’educazione, creatività amplificata…) e minimizzare i rischi (disuguaglianze, abusi di potere, minacce alla sicurezza).

In conclusione, l’intelligenza artificiale si presenta come uno strumento potentissimo: plasmare un futuro in cui sia al servizio dell’umanità – e non viceversa – è la sfida cruciale dei prossimi anni. Con lungimiranza, preparazione e cooperazione internazionale, l’IA potrà davvero aprire una nuova era di prosperità e conoscenza condivisa.