11 suggerimenti e trucchi per ottimizzare la velocità di scansione e aiutare le pagine web a essere sempre più visibili nelle serp.

Indice dei contenuti

ToggleBen sappiamo quanto sia lunga e faticosa la salita, e quanto lavoro ci sia dietro la realizzazione di un sito web e della sua relativa indicizzazione.

Ma è proprio quando le pagine web si posizionano e salgono nella indicizzazione che spesso i SEO e i webmaster iniziano a lavorare meno sulla gestione del progetto, pensando che basti costantemente inserire contenuto nuovo per aumentare l’indicizzazione totale.

Niente di più falso e scontato. Qualsiasi progetto web che si rispetti ha bisogno di cura e costante manutenzione e alcuni trucchi e suggerimenti possono aiutare a velocizzare queste procedure.

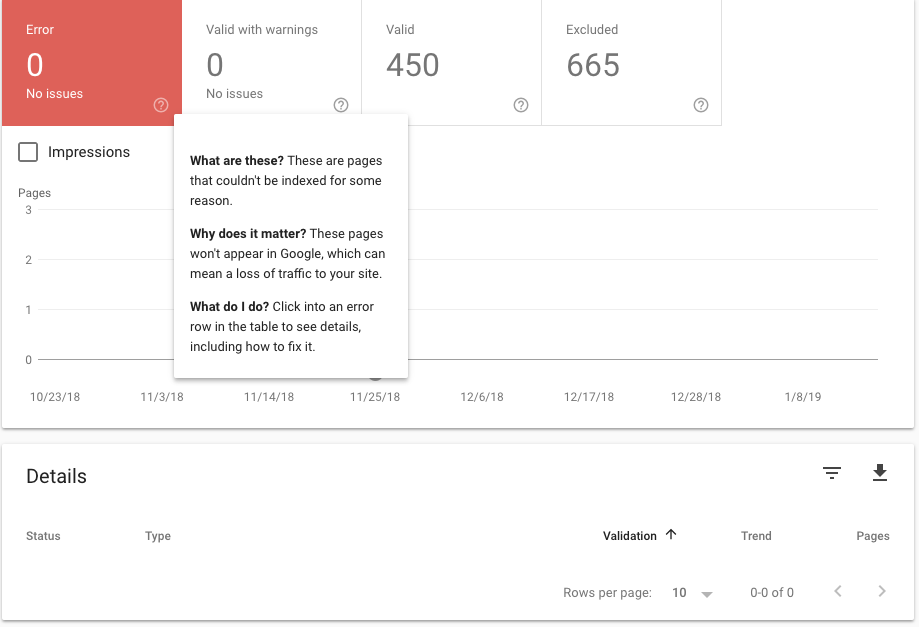

Monitorare lo stato di scansione con Google Search Console

È sempre bene controllare lo stato della scansione di ogni sito web ogni 30-60 giorni così da poter identificare potenziali errori che influiscono sul rendimento generale.

È letteralmente il primo passo della SEO: senza di essa, tutti gli altri sforzi sono nulli.

Proprio lì sulla barra laterale, possiamo controllare lo stato della scansione nella scheda indice.

Se si desidera rimuovere l’accesso a una determinata pagina web, possiamo comunicarlo direttamente alla Search Console . Questo è utile se una pagina viene temporaneamente reindirizzata o ha un errore 404.

Il parametro 410 rimuove, invece, in modo permanente una pagina dall’indice, quindi bisogna fare attenzione all’utilizzo dell’opzione onde non causare operazioni definitive.

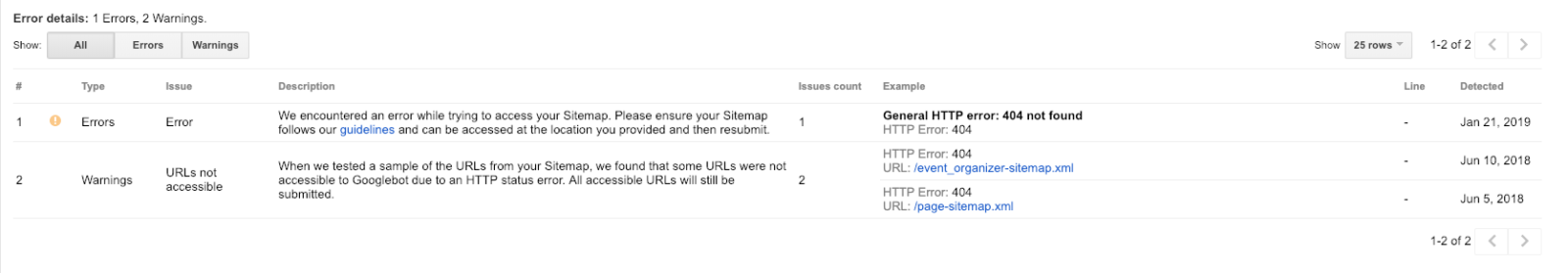

Errori e soluzioni comuni di scansione

Se in un sito web viene segnalato un errore di scansione, potrebbe richiedere una soluzione semplice o essere indicativo di un problema tecnico molto più grande.

Gli errori di scansione più comuni sono:

- Errori DNS

- Errori del server

- Errori di Robots.txt

- 404 errori

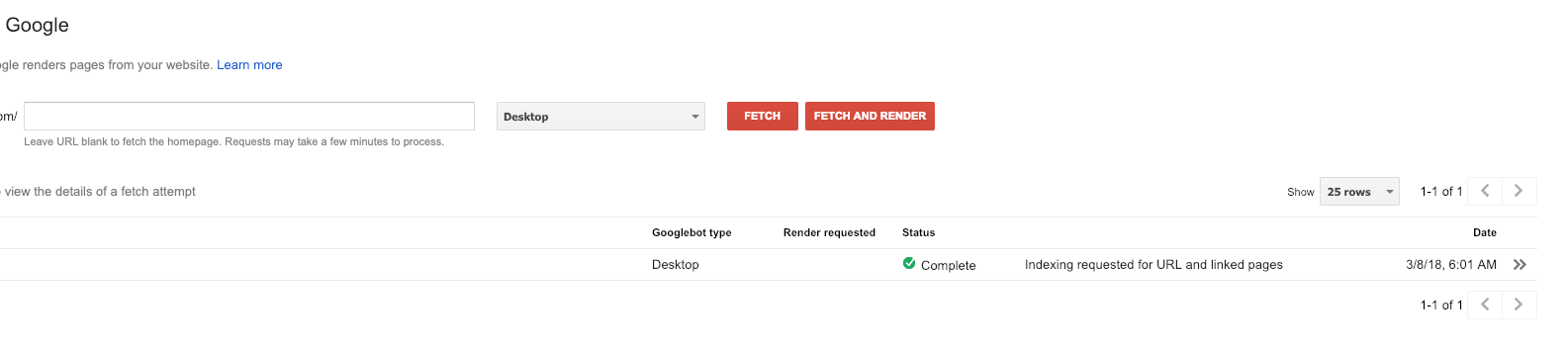

Per diagnosticare alcuni di questi errori, possiamo utilizzare lo strumento visualizza come Google per vedere in che modo Google visualizzi effettivamente il sito.

Il mancato recupero e rendering di una pagina può essere indicativo di un errore DNS più profondo che dovrà essere risolto dal provider DNS.

La risoluzione di un errore del server richiede una diagnosi specifica a cui è possibile fare riferimento in questa guida. Gli errori più comuni includono:

- Tempo scaduto

- Connessione rifiutata

- Connessione fallita

- Connetti il timeout

- Nessuna risposta

Nella maggior parte dei casi, un errore del server è in genere temporaneo, sebbene un problema persistente potrebbe richiedere di contattare direttamente l’hosting provider.

Gli errori robots.txt, d’altra parte, potrebbero essere più problematici. Se il file robots.txt restituisce un errore di 200 o 404, significa che i motori di ricerca hanno difficoltà a recuperare questo file.

Possiamo quindi inviare una sitemap contenente il robots.txt o evitare del tutto il protocollo, optando manualmente per le pagine noindex che potrebbero avere i problemi di scansione.

La risoluzione rapida di questi errori garantirà che tutte le pagine di destinazione vengano scansionate e indicizzate alla successiva scansione dei motori di ricerca del tuo sito.

Creare pagine web ottimizzate per dispositivi mobili

Con l’arrivo dell’indice mobile-first, dobbiamo anche ottimizzare le nostre pagine per visualizzarle sull’indice mobile.

La buona notizia è che la versione desktop verrà comunque indicizzata e visualizzata sotto l’indice mobile se non esiste una copia ottimizzata per i dispositivi mobili.

La cattiva notizia è che il ranking potrebbe risentirne.

Ci sono molte modifiche tecniche che possono rendere immediatamente più mobile il sito web, tra cui:

- Implementazione di un web design reattivo.

- Inserimento del meta tag del punto di vista nel contenuto.

- Minimizzare le risorse in-page (CSS e JS).

- Tagging delle pagine con la cache AMP.

- Ottimizzazione e compressione delle immagini con tempi di caricamento più rapidi.

- Riduzione delle dimensioni degli elementi dell’interfaccia utente della pagina.

Bisogna quindi assicurarsi di testare il sito web su una piattaforma mobile e scansionarlo tramite Google Pagespeed Insights. La velocità della pagina è un fattore di classifica importante e può influire sulla velocità con cui i motori di ricerca possono eseguire la scansione stessa.

Aggiornare il contenuto regolarmente

I motori di ricerca eseguono la scansione del sito più regolarmente se vengono pubblicati costantemente nuovi contenuti. Ciò è particolarmente utile per gli editori che hanno bisogno che i nuovi articoli vengano indicizzati in modo regolare.

La produzione di contenuti su base regolare segnala ai motori di ricerca che il sito migliora costantemente e pubblica nuovi contenuti e pertanto deve essere sottoposto più spesso a scansione per raggiungere il pubblico previsto.

Inviare una sitemap a ciascun motore di ricerca

Uno dei migliori suggerimenti per l’indicizzazione fino ad oggi è quello di continuare a inviare una sitemap a Google Search Console e a Bing Webmaster Tools.

Possiamo quindi creare una versione XML utilizzando un generatore di sitemap o crearne una manualmente in Google Search Console codificando la versione canonica di ogni pagina che contiene contenuti duplicati.

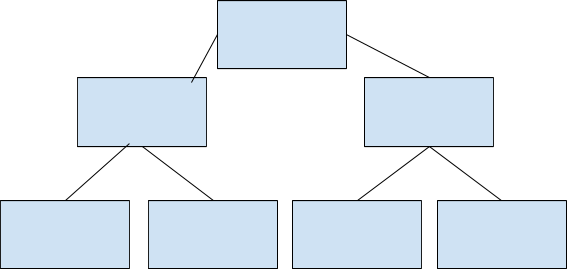

Ottimizzare l’architettura del sito web

Stabilire un’architettura di informazioni coerente è fondamentale per garantire che il sito web non sia solo indicizzato correttamente, ma anche organizzato in modo corretto.

La creazione delle categorie dei servizi principali in cui possono essere presenti le pagine web correlate può aiutare ulteriormente i motori di ricerca a indicizzare velocemente ed in modo corretto il contenuto della pagina web in specifiche categorie, soprattutto quando l’intento potrebbe non essere chiaro.

Collegamento diretto alle pagine web isolate

Se una pagina web di un sito o di un sottodominio viene creata in isolamento o si verifica un errore che impedisce di eseguire la corretta scansione, è possibile indicizzarla acquisendo un collegamento su un dominio esterno. Questa è una strategia particolarmente utile per promuovere nuovi contenuti sul sito web e ottenerne l’indicizzazione più veloce.

Per eseguire in modo corretto tale operazione bisogna porre molta attenzione ai syndicating content poiché i motori di ricerca potrebbero ignorare le syndicated page creando errori duplicati se non correttamente canonicizzati.

Ridurre le risorse nella pagina e aumentare i tempi di caricamento

Costringere i motori di ricerca a eseguire la scansione di immagini di grandi dimensioni e non ottimizzate mangerà il “budget di ricerca per l’indicizzazione” e impedirà che il sito venga indicizzato più spesso.

I motori di ricerca hanno anche difficoltà a scansionare determinati elementi di back-end dei siti web. Ad esempio, Google e Bing hanno storicamente difficoltà a eseguire la scansione dei JavaScript.

Anche alcune risorse come Flash e CSS possono funzionare male (o addirittura non essere visibili) su dispositivi mobili e consumare il crawl budget.

Bisogna quindi sempre assicurarsi di ottimizzare la singola pagina web per aumentare il più possibile la velocità, soprattutto su dispositivi mobili, riducendo le risorse in-page, come i CSS. Un altro consiglio è quello di abilitare la memorizzazione nella cache e la compressione per aiutare gli spider a eseguire la scansione del sito più velocemente.

Correggere le pagine con tag Noindex

Quando viene realizzato un sito web, può essere logico implementare un tag noindex in tutte quelle pagine che possono essere duplicate o destinate solo agli utenti che intraprendono una determinata azione.

Indipendentemente da ciò, è possibile identificare le pagine web con tag noindex che non possono essere sottoposte a scansione utilizzando uno strumento online gratuito come Screaming Frog.

Il plugin Yoast per WordPress permette invece di cambiare facilmente una pagina da index a noindex. La stessa operazione può essere fatta manualmente dal backend delle pagine del sito.

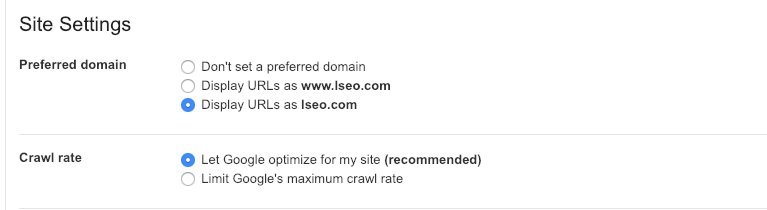

Impostare una frequenza di scansione personalizzata

Nella vecchia versione di Google Search Console, è possibile rallentare o personalizzare la velocità di scansione se si ritiene che gli spider di Google possano avere un impatto negativo sul sito.

Ciò consente inoltre al sito web di apportare le modifiche necessarie in caso di riprogettazione o migrazione (vedi seconda spunta nello screenshot qui sotto).

Eliminare il contenuto duplicato

Sappiamo bene come una eccessiva quantità di contenuto duplicato rallenti in modo significativo la velocità di scansione andando ad aumentare il crawl budget.

È possibile eliminare questi problemi bloccando l’indicizzazione di queste pagine o inserendo un canonical tag sulla pagina che si desidera indicizzare.

Altro errore che spesso inavvertitamente succede, e che si “gioca” sulla stessa falsariga del precedente, è che i motori di ricerca scambino pagine simili come contenuti duplicati durante l’indicizzazione. Vale quindi la pena ottimizzare i meta tag di ogni singola pagina per evitare l’annoso problema.

Bloccare con gli spider le pagine che si vogliono scansionare

Potrebbero esserci casi in cui un SEO o un webmaster voglia impedire ai motori di ricerca di eseguire la scansione di una pagina specifica. È possibile farlo con i seguenti metodi:

- Posizionare un tag noindex.

- Inserire l’URL in un file robots.txt.

- Cancellare del tutto la pagina.

Questo può anche aiutare i crawling a funzionare in modo più efficiente, invece di forzare i motori di ricerca a cercare i contenuti duplicati.

[via searchenginejournal.com]